在数字时代,内容传播的广度与深度前所未有地依赖用户互动数据,点赞、评论成为衡量内容价值的重要标尺。然而,这一机制催生了恶意点赞刷评论的灰色产业——通过机器账号、水军集群等技术手段人为制造虚假流量,不仅扭曲内容生态的真实性,更对平台、创作者及用户权益构成系统性威胁。应对这一问题,需从技术治理、平台机制、行业自律到用户认知的多维度协同,构建抵御虚假互动的“免疫系统”。

恶意点赞刷评论的本质是数据造假与信任透支。其技术内核已从早期的人工手动刷量,进化为基于AI模拟真实用户行为的自动化操作:通过批量注册“养号”形成账号矩阵,结合设备指纹伪造、地理位置模拟等技术,使虚假点赞、评论在数据维度上难以与传统人工行为区分。更隐蔽的是“定向刷量”——针对特定内容(如竞品视频、负面新闻)进行集中打压或抬升,形成“流量操控”的舆论陷阱。这种行为直接破坏了平台的内容推荐算法:当虚假数据干扰了用户真实偏好,优质内容可能因缺乏初始流量而沉没,低质或恶意内容却可通过刷量获得曝光,形成“劣币驱逐良币”的恶性循环。

对创作者而言,恶意刷量带来的伤害是双重的。短期看,虚假数据可能误导创作方向——某美妆博主若因刷量误判某款产品受众偏好,后续内容持续投入却遭遇流量断崖;长期则消耗用户信任,当粉丝发现评论区充斥着“复制粘贴式”好评或无实质内容的恶意差评,对创作者的专业度将产生根本性质疑。更严重的是,刷量行为已形成黑色产业链:一条“10万点赞+5万评论”的套餐价格低至数百元,平台若缺乏有效治理,将纵容“流量至上”的畸形价值观,挤压真正深耕内容的创作者生存空间。

技术层面的防御需从“被动识别”转向“主动拦截”。当前主流平台采用的异常检测模型,多基于“行为特征+数据规律”双重维度:例如识别账号在短时间内高频互动、地理位置跳变、设备型号集中等异常行为,或通过图神经网络分析账号间的关联性,揪出“水军集群”。但技术对抗永无止境,新型刷量工具已开始采用“模拟真实用户行为链路”——如随机间隔点赞、评论内容加入emoji变体、甚至模拟用户滑动页面的停留时间,这让传统基于阈值的检测算法失效。未来需引入“动态风控体系”:将用户画像、内容属性、场景特征等多维度数据输入机器学习模型,实时生成“刷量风险评分”,对高风险行为触发二次验证(如人脸识别、答题互动),从源头提升造假成本。

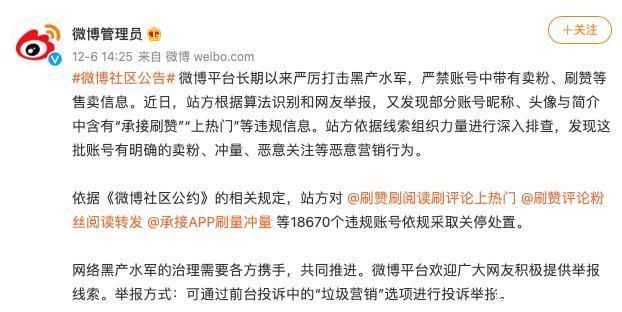

平台治理的核心在于建立“数据真实性”的制度保障。这需要完善从内容发布到数据呈现的全链路规则:例如对异常互动内容强制标注“数据异常”提示,降低其在推荐页的权重;建立“刷量黑名单”制度,对参与虚假互动的账号实施阶梯处罚,从限流封号至纳入行业共享信用体系;同时引入第三方审计机构,定期公布平台内容数据的真实性与治理成效,接受社会监督。值得注意的是,平台需平衡“严格治理”与“用户体验”——过度审核可能误伤真实用户的正常互动,例如多设备登录、集中时段评论等场景,需通过用户行为画像精准区分“善意互动”与“恶意造假”,避免“一刀切”导致的用户流失。

创作者的自主防御能力同样关键。面对刷量乱象,优质内容是抵御虚假数据的“终极武器”——当内容具备强情感共鸣或实用价值,用户自发的真实互动会形成“数据护城河”,使刷量行为难以掩盖其渺小。同时,创作者需善用平台提供的数据分析工具:通过“粉丝画像”功能识别异常账号(如注册时间短、无历史互动),及时清理恶意评论;对异常流量波动保持敏感,例如某条内容突然出现高点赞但零评论,可能预示刷量风险,可主动向平台举报。此外,创作者可建立“社区反刷量共识”——例如在评论区引导用户“拒绝虚假流量,支持真实表达”,形成用户群体的自我净化机制。

用户认知的觉醒是治理恶意刷量的社会基础。当前多数用户对刷量行为的危害认知不足,甚至将其视为“流量竞争的正常手段”。平台需通过内容教育(如弹窗提示、科普文章)让用户明白:虚假互动最终损害的是自身权益——当推荐算法被污染,用户获取的信息质量将直线下降。同时,可开发“数据真实性辅助工具”,例如插件显示内容的“真实互动率”(剔除异常数据后),帮助用户快速辨别优质内容。只有当用户形成“用脚投票”的自觉,拒绝为刷量内容点赞、评论,才能从需求端切断黑色产业链的生存土壤。

恶意点赞刷评论问题的解决,本质是数字时代“内容真实性”的保卫战。随着元宇宙、AIGC等新技术的发展,未来内容交互形式将更加多元,虚假互动的伪装手段也会不断升级。这要求技术、平台、创作者与用户形成“治理共同体”:技术方需持续迭代防御算法,平台方需坚守数据真实性的底线,创作者需以内容价值赢得信任,用户需提升媒介素养主动抵制虚假。唯有如此,才能构建一个让优质内容自然生长、真实互动得到尊重的数字生态,让每一次点赞、每一条评论都成为连接人与内容的真诚纽带。