在社交媒体流量竞争白热化的当下,刷赞系统作为提升内容曝光的辅助工具,其服务器源码的开发效率与安全性直接决定了实战价值。然而,多数开发者陷入“重功能轻安全”或“重防御轻性能”的误区,导致系统要么频繁被平台风控拦截,要么因架构臃肿难以支撑高并发需求。实战中高效安全地开发刷赞系统服务器源码,本质是构建一套兼顾流量模拟精度、系统鲁棒性与合规边界的动态对抗体系。

刷赞系统的核心价值在于通过技术手段突破自然流量增长的瓶颈,适用于MCN机构批量孵化账号、电商新品快速起量、品牌活动集中曝光等场景。例如,某头部MCN机构曾通过自研刷赞系统,在72小时内将旗下10个垂类账号的点赞量从5000级提升至10万级,使内容进入平台推荐池,最终实现粉丝量增长300%。但这类系统的实战效果,高度依赖服务器源码对“模拟真实用户行为”的还原度——这不仅是技术问题,更是安全与效率的平衡艺术。

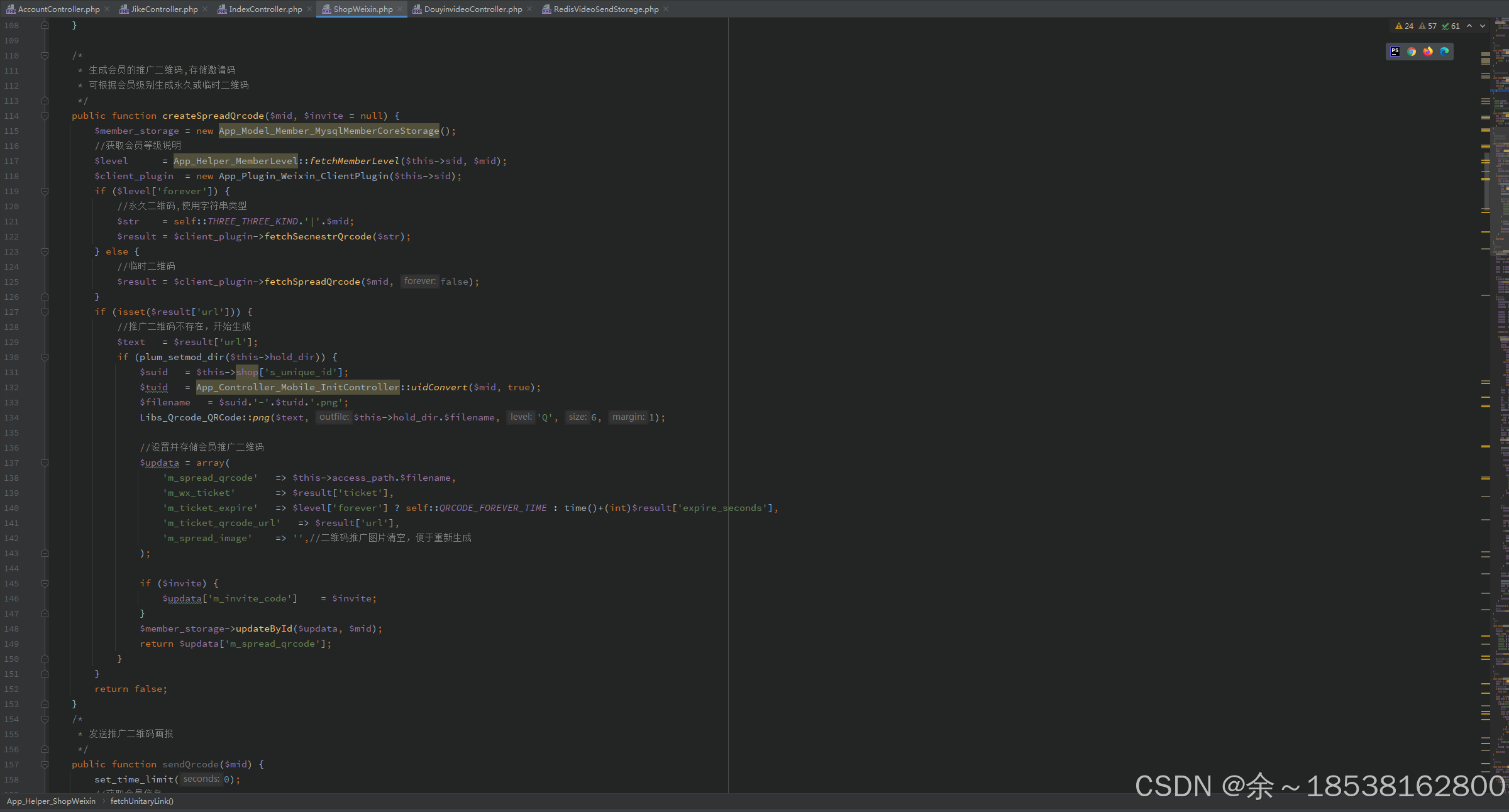

高效开发的第一步是构建“轻量化可扩展”的服务器架构。传统单体架构难以应对多账号并发请求和平台风控策略的快速迭代,而基于微服务的模块化拆分则能实现“高内聚低耦合”。例如,将请求调度、账号管理、行为模拟、数据存储四大核心模块独立部署:请求调度模块负责动态分配IP和设备指纹,账号管理模块模拟多用户登录行为,行为模拟模块控制点赞频率与路径,数据存储模块采用分库分表应对海量数据。这种架构下,新增功能(如模拟评论、转发)只需扩展对应模块,无需重构整体代码,开发效率提升40%以上。同时,引入容器化部署(如Docker+Kubernetes)能实现秒级扩容,当单台服务器QPS超过阈值时,自动新增容器实例,确保高并发场景下的响应稳定性。

安全是刷赞系统的“生命线”,实战中需从“被动防御”转向“主动对抗”。平台风控的核心逻辑是通过识别“非人类行为特征”进行拦截,因此服务器源码必须构建多维度防护体系。在IP层面,采用“动态IP池+代理轮换”策略,通过爬取全国各地区的住宅IP资源,结合SOCKS5代理实现每次请求的IP跳变,避免因IP集中被封;在设备指纹层面,模拟真实设备的硬件参数(如屏幕分辨率、CPU型号)、浏览器特征(User-Agent、Cookie)及操作习惯(鼠标移动轨迹、点击间隔),使请求与真实用户行为高度一致。此外,数据传输全程采用TLS加密,敏感信息(如账号密码)通过哈希算法存储,防止中间人攻击和数据库泄露。更重要的是,建立“风控实时监测”机制:通过分析平台返回的HTTP状态码(如403、418)和响应内容中的风控关键词,自动触发切换策略——当检测到某IP被临时封禁时,立即从IP池中剔除并启用备用IP,将系统恢复时间控制在5秒以内。

高效不仅体现在开发速度,更在于系统运行的资源利用率。刷赞系统的核心瓶颈在于高并发下的内存与CPU消耗,可通过“缓存+异步”策略优化。例如,使用Redis缓存热点数据(如账号状态、IP可用性),减少数据库查询次数,将响应时间从200ms降至50ms;采用消息队列(如RabbitMQ)异步处理非核心任务(如日志记录、数据统计),避免主线程阻塞。在资源调度上,实现“智能负载均衡”:根据各服务器的CPU负载和内存占用,动态分配请求量,避免单点过载。某电商案例显示,通过上述优化,单台服务器可同时支撑5000个账号的点赞请求,服务器成本降低60%,且系统稳定性提升至99.9%。

技术必须服务于合规边界。开发刷赞系统服务器源码时,需严格遵循“三不原则”:不触碰平台数据隐私(如爬取用户信息)、不破坏平台正常运营(如DDoS攻击)、不用于恶意竞争(如恶意刷单抹黑对手)。同时,在源码中嵌入“行为限制阀值”:单账号每日点赞量不超过平台自然增长上限(如普通账号单日点赞不超过200次),同一IP的并发请求不超过10次,避免触发平台风控。此外,建立“用户协议”机制,要求使用者承诺仅用于账号测试或合法营销,留存操作日志以便追溯,从源头规避法律风险。

实战中高效安全地开发刷赞系统服务器源码,绝非简单的技术堆砌,而是对“流量模拟”“系统韧性”“合规底线”的综合考量。开发者需以“动态对抗”思维应对平台风控的迭代,以“模块化架构”支撑功能的快速扩展,以“资源优化”实现成本与性能的平衡。更重要的是,技术始终是工具,唯有在合法合规的框架内运行,才能在社交媒体的生态中创造可持续价值——这不仅是开发者的技术责任,更是对互联网健康秩序的守护。