在刷赞业务生态中,分站与主站的协同架构是支撑规模化运营的核心骨架,其设计直接决定了业务效率、风险控制能力与数据流转的稳定性。随着社交媒体流量价值的持续攀升,刷赞需求从零散化转向集群化,主站作为全局管理中心,需承担任务调度、数据聚合与风控中枢的职能;分站则作为分布式执行节点,聚焦区域化用户触达与精细化任务落地。二者通过高效的数据交互机制形成闭环,既解决了单点架构的扩展瓶颈,又应对了多平台、多场景下的复杂运营需求。

一、主站与分站的架构设计:分层解耦与功能定位

(一)主站:全局管理中心与智能调度中枢

主站架构的核心是“集中管控+智能决策”,采用微服务化分层设计,主要包含四大模块:

全局任务调度引擎是主站的“大脑”,基于用户画像、任务优先级、分站负载能力等维度,通过动态权重算法将刷赞任务精准分配至分站。例如,针对抖音平台的短视频点赞任务,调度引擎会结合分站所在区域的用户活跃时段、设备类型分布(如iOS/Android占比),以及分站的历史执行成功率(如≥95%的分站优先获得高权重任务),实现任务与资源的最优匹配。

数据中台则承担“数据仓库”职能,汇聚分站上传的执行数据(如点赞完成率、用户留存率、平台风控触发率)、用户行为数据(如目标账号的粉丝互动率、内容传播路径)以及外部环境数据(如平台算法更新动态、热点事件舆情),通过机器学习模型构建任务效果评估体系,为主站调度策略提供数据支撑。

风控策略中心是主站的“安全阀”,通过实时监控分站上传的执行日志(如点赞行为的时间戳分布、设备指纹重复率),结合第三方风控API(如检测目标账号是否被平台标记为“异常互动”),动态调整任务执行参数(如降低单日点赞频次、切换模拟真人操作模式),规避平台封禁风险。

监控运维平台则通过Prometheus+Grafana等技术栈,对主站各模块的CPU使用率、任务延迟、分站在线率等关键指标进行实时监控,并设置自动告警机制(如分站离线率超过10%触发告警),确保系统高可用性。

(二)分站:分布式执行节点与区域化运营载体

分站架构的设计原则是“轻量化部署+本地化执行”,通常以区域或用户群体为单位划分,每个分站独立承担任务接收、执行与反馈职能,核心模块包括:

任务接收层通过轻量级消息队列(如RabbitMQ)与主站调度引擎对接,实时拉取待分配任务。为降低网络延迟,分站会缓存主站下发的任务模板(如不同平台的点赞操作路径、参数配置),支持离线状态下本地任务队列管理。

执行引擎层是分站的“手脚”,核心是模拟真实用户行为。以微信朋友圈点赞为例,执行引擎会通过自动化脚本(如基于Selenium的UI自动化或移动端Hook技术)模拟用户滑动、点击、停留等动作,并注入随机延迟(如3-8秒)和设备特征(如不同分辨率、IMEI号),避免被平台识别为机器操作。部分高级分站还会接入“真人众包”能力,通过聚合兼职用户的手动点赞行为,进一步提升任务真实性。

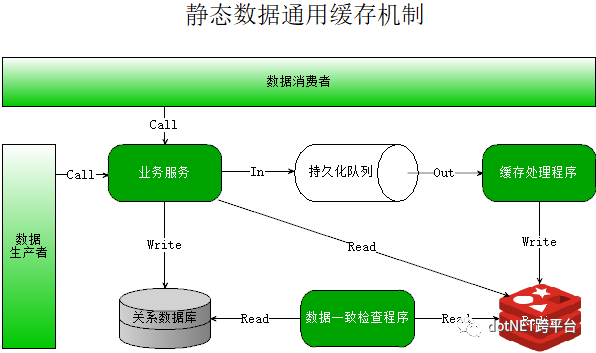

本地缓存层采用Redis等内存数据库,存储分站执行过程中的临时数据(如任务进度、用户Token),减少对主站数据库的直接访问压力,同时支持任务断点续传(如网络中断后从缓存中恢复执行进度)。

状态反馈层则通过HTTP/HTTPS协议,向主站数据中台上传执行结果(如任务ID、完成时间、是否触发风控),并附带本地日志(如操作截图、设备指纹),为主站效果评估与风控优化提供一手数据。

二、数据交互机制:安全高效的全链路流转

分站与主站的数据交互是业务生态的“血脉”,其设计需兼顾实时性、安全性与一致性,主要涵盖任务下发、执行反馈、数据同步三大场景,并通过多重技术手段保障流转效率。

(一)任务下发:异步化与优先级调度

主站向分站下发任务时,采用“异步+优先级”机制:主站调度引擎将任务封装为JSON格式的消息体(包含任务目标、执行参数、截止时间等),通过Kafka消息队列推送给分站。消息队列的分区策略(如按分站ID哈希分区)确保同一分站的任务顺序执行,避免任务竞争;而消息的优先级字段(如高优先级任务标记为“urgent”)则让分站执行引擎优先处理紧急任务(如客户加急的明星账号点赞需求)。

为降低网络抖动对任务分发的影响,主站还会实现消息重试机制:若分站在30秒内未消费消息,消息队列会将消息重新投递至其他同负载分站;若重试3次仍未成功,则触发告警并标记该分站为“异常状态”,暂停其任务接收权限。

(二)执行反馈:实时监控与异常上报

分站完成点赞任务后,需通过HTTPS协议向主站反馈执行结果,数据交互流程包含三层校验:

第一层是数据签名校验:分站使用预共享密钥(HMAC-SHA256)对反馈数据进行签名,主站通过验证签名确保数据未被篡改;

第二层是业务逻辑校验:主站检查反馈数据中的任务ID是否存在、完成时间是否在任务截止时间前、点赞数量是否符合任务要求(如任务要求“点赞100次”,反馈数据需为100±2),避免分站虚报完成量;

第三层是异常标记:若分站在执行过程中触发平台风控(如收到“频繁操作”提示),需在反馈数据中标记“风控触发”字段,并附带异常详情(如平台提示语、操作时间戳),主站风控策略中心会基于此动态调整后续任务参数(如降低该分站的任务执行频次)。

(三)数据同步:批处理与增量更新

对于需要长期存储的历史数据(如分站执行效率统计、用户行为分析),主站与分站采用“增量同步+定期批处理”机制:分站每日凌晨通过ETL工具(如DataX)将当日执行数据导出为CSV文件,通过FTP/SFTP协议上传至主站数据仓库;主站则通过Spark Streaming对实时反馈数据进行增量处理,与批处理数据合并后构建数据立方体(Data Cube),支持多维度分析(如按区域、平台、时间统计点赞转化率)。

为保障数据一致性,主站会实现“对账机制”:每日生成任务执行对账单,对比主站下发的任务总数与分站反馈的成功数、失败数,若差异率超过1%,则触发数据修复流程(如从分站本地缓存中找回丢失的执行日志)。

三、架构设计的价值与挑战:效率与风险的动态平衡

(一)核心价值:规模化与精细化的统一

分站-主站架构的核心价值在于实现了“规模化扩展”与“精细化运营”的统一:

- 规模化扩展:通过分布式分站部署,业务承载能力从单站的千级并发提升至万级甚至十万级,轻松应对“双十一”等流量高峰期的点赞需求;

- 精细化运营:主站通过分析分站反馈的区域数据(如华东地区用户偏好“娱乐类”内容点赞),可优化任务分发策略,将特定类型任务优先分配给对应区域的分站,提升点赞转化率;

- 风险隔离:分站独立运营,单点分站被封禁不会影响全局业务,主站可通过快速切换任务至其他分站,将损失控制在最小范围。

(二)现实挑战:合规与技术的双重压力

尽管架构设计提升了业务效率,但刷赞业务本身处于平台监管的灰色地带,面临两大核心挑战:

合规风险:随着各大平台(如抖音、小红书)强化反作弊机制,分站执行引擎需不断升级模拟技术(如从UI自动化转向基于AI的行为模拟),但技术迭代始终滞后于平台算法更新,导致任务失败率波动较大;

数据安全:分站需存储用户账号密码、设备指纹等敏感数据,一旦分站服务器被攻击,可能引发数据泄露风险,主站需通过数据加密(如AES-256)、权限最小化原则(如分站仅能访问自身任务数据)降低安全风险。

结语

在刷赞业务生态中,分站与主站的架构设计是技术能力与业务需求的深度耦合产物——主站以“全局调度+智能决策”实现资源优化配置,分站以“分布式执行+本地化运营”保障任务落地效率,二者通过安全高效的数据交互机制形成闭环。然而,随着监管趋严与平台反作弊技术升级,单纯的架构优化已无法支撑业务持续,唯有将合规风控嵌入架构设计(如引入区块链技术存证任务执行过程),才能在效率与风险间找到动态平衡,推动生态从“流量造假”向“价值赋能”的理性转型。