维盟万兆网卡怎么设置才最佳?效果提升秘诀!维盟万兆网卡作为企业级与高性能用户构建高速网络的核心组件,其性能释放绝非简单的“插即用”即可实现。不同于千兆网卡的“够用就好”,万兆环境的复杂性要求用户必须通过精细化设置,在硬件兼容、系统优化、场景适配等多维度协同发力,才能真正挖掘其万兆潜力。本文将从实战角度出发,拆解维盟万兆网卡的最佳设置路径,揭示性能提升的关键秘诀,帮助用户告别“带宽虚标”,实现网络效能最大化。

一、硬件基础:万兆性能的“地基工程”

维盟万兆网卡的优化,始于对硬件环境的严格把控。许多用户认为“只要网卡是万兆,就能跑满万兆”,却忽略了底层硬件的瓶颈制约。硬件兼容性是性能释放的前提,若地基不稳,再精细的设置也只是空中楼阁。

首先,PCIe通道版本直接影响网卡带宽上限。维盟主流万兆网卡多采用PCIe x8接口,理论上需搭配PCIe 3.0 x8通道(带宽约7.88GB/s)或PCIe 4.0 x4通道(带宽约7.88GB/s)才能避免瓶颈。用户需在主板BIOS中确认PCIe插槽版本与速率——例如,部分老旧主板仅支持PCIe 2.0 x8(带宽约4GB/s),即便网卡性能再强,也无法突破带宽限制。其次,CPU处理能力不可忽视:万兆网络的数据包转发依赖CPU中断处理,若CPU性能不足(如低功耗处理器或老旧架构),网卡可能因中断积压导致丢包或延迟,此时需开启网卡的“中断合并”(Interrupt Moderation)功能,通过合并多个中断请求减轻CPU负担,但需注意合并值过高会增加延迟,需根据业务场景动态调整。

此外,线材与接口的“隐性损耗”常被忽视。维盟万兆网卡需搭配Cat6a及以上等级的屏蔽网线(STP/FTP),或光纤链路,普通Cat5/6线材在万兆速率下信号衰减严重,可能导致速率跌至千兆甚至百兆。接口方面,需确认RJ45接口是否支持10GBase-T标准,部分廉价接口因屏蔽设计不良,在万兆环境下出现误码率飙升。硬件层面的“精打细算”,是维盟万兆网卡发挥最佳效果的第一步。

二、系统配置:释放性能的“软件引擎”

硬件到位后,操作系统层面的参数优化成为性能提升的核心。维盟万兆网卡在不同操作系统(Windows Server、Linux、ESXi等)中的配置逻辑存在差异,需针对性调整关键参数,才能打通“硬件-系统-应用”的性能通路。

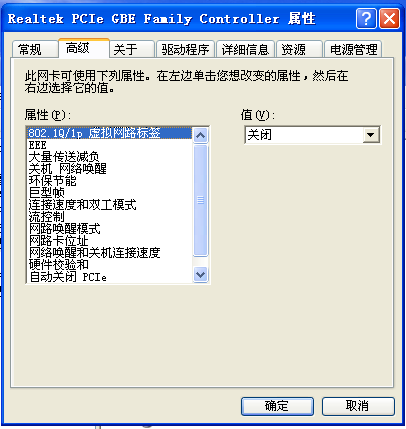

在Windows系统中,网卡的“高级属性”设置是优化重点。需关闭不必要的卸载功能(如IPv6卸载、巨型帧卸载),避免因协议栈处理不当导致丢包;启用“接收缓冲区”(Receive Buffer)和“发送缓冲区”(Transmit Buffer),缓冲区大小需根据网络环境动态调整——例如,在NAS存储场景下,建议将接收缓冲区设至64KB以上,以应对突发数据流;对于低延迟场景(如金融交易、游戏),则需调低缓冲区值,避免数据积压。此外,Windows的“QoS数据包计划程序”应开启并优先级标记,确保关键应用(如视频会议、VoIP)的带宽占用不受其他流量挤占。

Linux系统的优化则更侧重内核参数调优。以CentOS 7为例,需修改/etc/sysctl.conf文件,调整net.core.rmem_max和net.core.wmem_max(建议分别设至16777216字节,即16MB),扩大TCP接收/发送缓冲区上限;开启net.ipv4.tcp_bbr拥塞控制算法,替代传统的CUBIC算法,提升高带宽延迟积网络(BBR)的传输效率;对于Jumbo Frame(巨型帧)支持,需在网卡配置中设置MTU值为9000,并确保交换机、路由器全链路支持,否则会导致分片传输,反降低效率。虚拟化环境(如VMware ESXi)下,需将维盟网卡设置为“VMXNET3”模式(虚拟化专用驱动),并启用SR-IOV技术,实现虚拟机直通网卡,避免虚拟化软件的网络转发损耗。

三、驱动与固件:稳定性的“隐形守护者”

驱动程序与固件版本是维盟万兆网卡性能与稳定性的“隐形推手”。许多用户习惯依赖系统自动更新,或长期使用旧版驱动,却不知驱动与固件的迭代往往包含性能优化与兼容性修复。

维盟官方驱动是性能首选——与第三方驱动或系统自带驱动相比,官方驱动针对自家芯片方案(如Intel X550、I350系列)进行了深度适配,能更好地释放网卡硬件加速功能(如TCP/IP卸载校验、RSS接收方缩放)。建议用户从维盟官网下载最新稳定版驱动,安装时选择“自定义安装”,勾选“性能模式”而非“兼容模式”。对于Linux用户,需确保内核版本与驱动兼容,例如内核5.4及以上版本对Intel X550的支持更为完善,可通过ethtool -i eth0命令查看驱动版本。

固件更新则常被忽略,但其重要性不亚于驱动。网卡固件相当于“硬件系统软件”,负责控制数据包的收发逻辑与错误校验。维盟官方会定期发布固件更新,修复因硬件设计缺陷导致的丢包、掉线问题,或优化功耗管理。更新固件时需注意:① 务必通过维盟管理工具或DOS模式更新,避免在Windows界面中操作断电风险;② 更新前备份当前固件,以防新版本不兼容可回退;③ 更新后需重新配置网卡参数,因固件可能重置默认设置。驱动与固件的“双轮驱动”,是维盟万兆网卡长期稳定运行的保障。

四、场景适配:从“通用设置”到“精准调优”

万兆网络的应用场景千差万别,维盟万兆网卡的“最佳设置”并非固定参数,而是需根据业务需求动态调整。脱离场景的优化,如同“刻舟求剑”,难以实现真正的性能提升。

在NAS存储场景中,数据传输以大块文件为主,对吞吐量要求极高。此时需重点启用Jumbo Frame(MTU=9000),减少TCP/IP协议栈的包头开销(普通帧MTU=1500,传输1GB文件需约70万个数据包,而巨型帧仅需约7万个),大幅提升CPU利用率与传输效率;同时,在NAS端开启“链接聚合”(LACP),将两块万兆网卡绑定为链路聚合组(LAG),实现双倍带宽(20Gbps)与冗余备份。

对于虚拟化场景(如Kubernetes集群),网络延迟与并发处理能力是关键。需关闭网卡的“巨型帧”,避免虚拟机间通信分片;启用RSS(接收方缩放)功能,将数据包分散至CPU核心并行处理,提升并发性能;结合SR-IOV技术,为每个虚拟机分配独立的虚拟网卡(VF),绕过虚拟交换机,实现接近物理机的网络性能。

在视频监控或流媒体场景中,实时性与稳定性优先。需设置QoS策略,优先保障视频流数据的带宽(如预留80%带宽用于视频传输,限制P2P下载等非关键流量);启用网卡的“流量整形”(Traffic Shaping),避免突发流量导致网络拥塞;同时,降低中断合并值(如设至32μs以下),减少数据包处理延迟,确保监控画面无卡顿。

五、维护与监测:性能长效的“动态校准”

维盟万兆网卡的“最佳设置”并非一劳永逸,需通过持续监测与动态调整,应对网络环境变化与硬件老化。性能监测是发现问题的基础,而动态校准是保持最佳状态的关键。

日常监测可借助专业工具:Windows用户可通过“Resource Monitor”查看网卡“带宽使用”“发送/接收字节数”等实时数据;Linux用户推荐使用iftop或nload,监控连接级流量与带宽占用;企业级环境则可部署Zabbix、Prometheus等监控系统,设置网卡丢包率、错误包数、带宽利用率等阈值告警。当发现速率下降时,需逐步排查:① 线材与接口是否松动(RJ45接口氧化会导致接触不良);② 系统资源是否瓶颈(CPU/内存占用过高);③ 网卡驱动是否过期(对比官方日志检查新版本);④ 网络设备是否支持(如交换机端口是否开启10G速率)。

硬件老化也是不可忽视的因素。网卡芯片长期高温工作可能导致性能降频,建议定期清理机箱灰尘,为网卡加装独立散热片(如被动散热片);电解电容老化会影响信号稳定性,若网卡使用超过3年,可考虑更换备件。通过“监测-排查-校准”的闭环维护,维盟万兆网卡的性能才能长期稳定在最佳状态。

维盟万兆网卡的“最佳设置”,本质是硬件基础、系统优化、场景适配与动态维护的系统工程。它没有放之四海而皆准的“万能参数”,却有“从需求出发,数据驱动优化”的核心逻辑。唯有深入理解技术原理,结合实际业务场景精细调校,才能让万兆网卡从“参数达标”走向“体验卓越”,真正成为企业数字化转型的“加速器”。记住,性能提升的秘诀不在于“堆砌高级功能”,而在于“让每个设置都精准服务于需求”,这既是技术调优的艺术,也是网络管理的智慧。