网络平台上的留言、点赞与刷票现象,已成为数字时代不可忽视的治理难题。这些互动数据本应是用户真实意愿的反映,却在技术代偿与利益驱动下异化为流量造假、舆论操控与公平竞争的温床。如何有效核查这些现象,不仅是平台维护公信力的必修课,更是构建清朗网络空间的关键命题。核查的核心并非简单的数据纠错,而是通过技术赋能与机制创新,重建用户信任与平台生态的正向循环。这一过程需从价值认知、技术路径到治理挑战,形成系统性解决方案。

一、核查的价值:从数据真实到生态健康的底层逻辑

网络互动数据的真实性,直接关系到平台的核心价值。在留言场景中,虚假评论、水军控评不仅误导用户决策,更扭曲公共舆论场的信息平衡——当一条商品留言下充斥着“复制粘贴式”的五星好评,消费者对平台的信任度将直线下降;当社会事件讨论区被批量恶意留言淹没,理性讨论的空间会被严重挤压。点赞数据的失真则更具隐蔽性,虚假点赞能制造“热门假象”,通过平台算法推荐机制形成“劣币驱逐良币”的恶性循环:优质内容因真实互动不足被埋没,低质内容却因虚假点赞获得流量倾斜,最终损害内容生态的多样性。

刷票行为的危害则直击公平底线。无论是明星打榜、活动投票还是商业评选,刷票都让规则让位于技术,破坏了参与者平等竞争的权利。更严重的是,刷票背后往往形成黑色产业链,通过“养号平台”“投票机器人”牟利,进一步助长网络空间的不正之风。因此,有效核查这些现象,本质上是守护平台“真实、公平、透明”的立身之本——只有当数据反映真实意愿,平台才能成为信息高效流通、价值正确传递的载体。

二、核查的技术路径:从规则引擎到智能识别的迭代升级

面对日益复杂的造假手段,核查技术需从“事后追溯”转向“事中监测+事前预防”,构建多维度、动态化的识别体系。

在留言核查领域,语义分析与行为特征识别是核心手段。传统基于关键词过滤的规则引擎已难以应对“变种水军话术”——如今的水军会使用谐音、符号拆分(如“绝绝子”写作“juejuezi”)或混合语言规避检测。而自然语言处理(NLP)技术可通过上下文语义理解,识别出与主题无关、情感倾向异常(如同一文案批量复制)、高频重复出现的留言。同时,结合用户画像分析,可捕捉“异常行为特征”:例如,新注册账号短时间内发表大量评论、登录IP集中于同一地域段、发言时间呈现规律性集中(如凌晨0-2点批量发布),这些均可能是水军账号的典型标签。某短视频平台通过“语义+行为”双模型,已将虚假评论识别率提升至92%,有效净化了评论区生态。

点赞真实性的核查则需聚焦“行为逻辑反常”。正常用户的点赞行为往往具有场景相关性(如美食视频下点赞)、时间分散性(非集中操作)及账号活性(长期历史互动)。而虚假点赞常表现为“秒赞”(发布瞬间集中出现)、跨账号异常关联(多个设备登录同一IP、设备指纹高度相似)、无差别点赞(对内容类型无关的账号批量点赞)。技术层面,可通过图神经网络(GNN)构建账号关系网络,识别“点赞团伙”;利用设备指纹技术,定位同一操作者控制的多个虚拟账号;结合时序分析模型,检测点赞量的异常波动(如线性增长而非自然增长曲线)。社交平台“微博”通过这类技术,已清理数亿条虚假点赞数据,显著提升了热搜榜单的公信力。

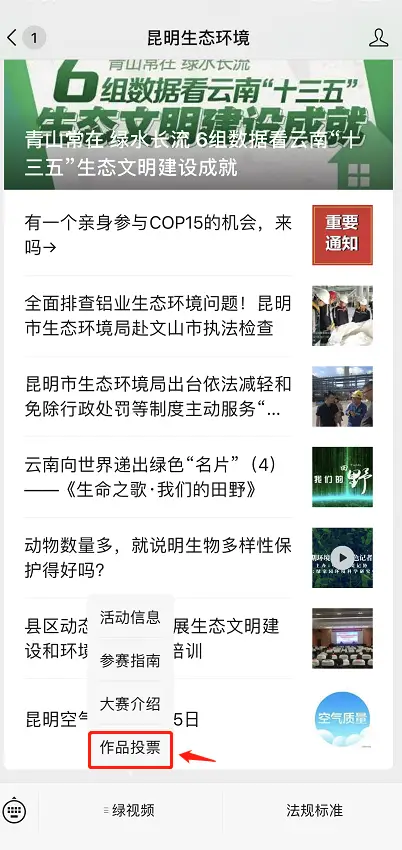

刷票监测的核心在于“票数增长规律与投票行为的合规性”。正常投票应遵循“一人一票、自愿参与”原则,而刷票常伴随“票数突增”(如短时间内票数增长超千倍)、投票IP高度集中(同一IP为不同账号投票)、投票设备异常(模拟器、Root设备集中投票)等问题。技术实现上,可通过多模态数据融合:一方面分析投票日志中的时间戳、IP地址、设备ID等结构化数据,建立“投票行为基线模型”,偏离基线的触发预警;另一方面引入图像识别技术,验证真人投票场景(如滑动验证码、人脸识别),过滤机器刷票。某电商平台在“618”促销活动中,通过实时监测投票异常波动,拦截了超80万次刷票行为,保障了活动公平性。

三、核查的挑战:技术对抗与治理平衡的现实困境

尽管核查技术不断迭代,但造假手段的“道高一尺”仍让治理面临多重挑战。

首当其冲的是“技术对抗的螺旋式升级”。水军与刷票团伙已形成产业化运作,通过“养号池”(长期运营真实账号模拟正常行为)、“代理IP池”(动态切换IP规避地域检测)、“模拟器集群”(模拟真实用户操作轨迹)等手段,规避传统识别模型。例如,部分黑产使用“真人养号”策略:通过模拟日常浏览、点赞、评论行为,将账号“养”成平台认证的“高活跃用户”,再利用这些账号进行虚假留言或投票,极大增加了识别难度。这种“以真实对抗虚假”的手段,倒逼核查技术从“单点检测”向“全链路追踪”升级——需覆盖账号注册、行为养成、数据生成、传播扩散的全流程,技术复杂度呈指数级增长。

其次是“核查效率与用户体验的平衡”。过度依赖技术核查可能误伤正常用户:例如,企业官方账号为感谢用户支持批量回复评论,可能被误判为“水军控评”;用户在热点事件下集中发表观点,可能触发“异常发言”预警。如何在精准识别与保障用户体验间找到平衡点,成为平台治理的难题。这要求核查模型需具备“场景化判断能力”——例如,区分“企业官方互动”与“恶意刷量”,识别“用户自发集中讨论”与“水军集中控评”,通过引入人工审核机制对机器预警进行二次校验,避免“一刀切”式的误判。

更深层的挑战在于“跨平台协作与标准缺失”。当前,虚假账号、刷票工具往往在不同平台间流动,单个平台的数据孤岛难以实现全链路追踪。例如,某水军平台可能在A平台养号,在B平台刷票,在C平台变现,若缺乏跨平台数据共享机制,各平台难以形成治理合力。同时,行业尚未建立统一的“数据真实性标准”,不同平台对“异常行为”的界定阈值不一,导致造假者“钻空子”现象频发。这亟需推动行业协作,制定数据真实性检测的通用规范,建立跨平台黑名单共享机制,从源头上压缩造假空间。

四、构建全链条核查机制:技术、制度与教育的协同发力

有效核查网络平台留言、点赞与刷票现象,需打破“技术万能论”的误区,构建“技术筑基+制度护航+教育引导”的全链条治理体系。

技术上,需推动“智能识别+人工复核”的双轮驱动。一方面,加大AI模型研发投入,引入深度学习、联邦学习等技术提升识别精准度,例如利用联邦学习在保护用户隐私的前提下,跨平台协作训练反作弊模型;另一方面,建立专业的人工审核团队,针对机器难以判断的复杂场景(如情感倾向模糊的留言、涉及争议性内容的投票)进行人工研判,确保核查结果的客观性。

制度上,需完善平台规则与违规惩戒机制。明确界定“虚假留言”“恶意点赞”“刷票行为”的具体标准,通过用户协议、社区公约等形式公示;建立“梯度惩戒”体系,对违规账号采取警告、限流、封号等处罚,对涉及违法犯罪的刷票团伙,及时向监管部门举报并配合调查。同时,引入第三方监督机制,邀请权威机构对平台数据真实性进行审计,增强核查结果的公信力。

教育上,需强化用户数据安全素养与诚信意识。通过平台公告、弹窗提示等方式,向用户普及刷票、虚假留言的危害及法律风险;鼓励用户主动举报异常行为,建立便捷的举报渠道与反馈机制;对积极参与举报的用户给予积分、权益等奖励,形成“全民监督”的治理氛围。唯有让用户认识到“真实互动是自身权益”,才能从源头上抵制造假行为。

网络空间的清朗,始于每一次真实互动的坚守。留言、点赞与刷票的核查,不仅是平台的技术命题,更是数字时代的社会治理课题。当技术能精准识别虚假,制度能有力约束违规,用户能自觉维护真实,网络平台才能真正成为传递价值、凝聚共识的良性场域。唯有让数据回归真实本质,数字生态的根基才能坚不可摧。