在短视频平台算法迭代加速的当下,微视作为腾讯生态重要组成部分,其点赞机制直接影响内容分发权重与创作者生态。然而,直接在公网测试点赞工具存在账号封禁、数据泄露等风险,localhost作为本地开发环境,为微视刷赞网站的合规测试与功能验证提供了安全可控的解决方案。本文将深入探讨微视刷赞网站在localhost上的使用逻辑、技术实现与核心价值,为开发者、内容研究者提供可落地的实践路径。

localhost环境的核心价值:合规测试的“安全区”

微视刷赞网站的本质是通过模拟真实用户行为,提升内容的互动数据,进而触发平台算法的推荐机制。但公网环境下的刷赞操作极易触发平台的反作弊系统——例如异常点赞频率、非活跃账号集中点赞等行为,轻则导致账号限流,重则永久封禁。而localhost(本地服务器环境)的封闭性恰好规避了这一风险:所有测试数据均在本地生成与交互,不涉及真实用户账号,不与微视服务器产生直接请求,本质上属于“离线状态下的逻辑验证”。这种“技术预演”模式,既符合《网络安全法》对数据安全的要求,又能精准验证工具功能,成为合规研究的必要环节。

环境搭建:从零开始部署本地测试平台

要在localhost上运行微视刷赞网站,需完成三步核心准备:本地环境配置、工具源码部署与模拟数据生成。

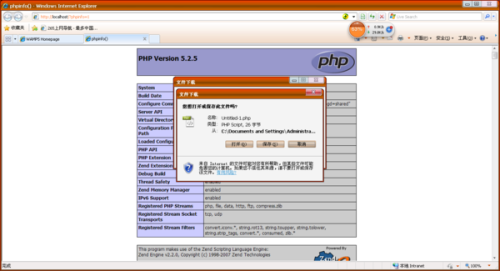

首先,本地环境需支持Web服务与数据库运行。以Windows系统为例,可安装XAMPP集成包(含Apache服务器、MySQL数据库、PHP环境),或使用Docker容器化部署(通过docker-compose一键搭建LNMP环境)。Linux用户则可直接通过apt/yum安装nginx+MariaDB,确保环境变量与路径配置正确——这是后续工具运行的基础,也是新手最容易因路径错误导致测试失败的关键环节。

其次,工具源码的获取与部署需注意合规边界。目前开源社区存在部分“微视刷赞网站”的模拟项目(如基于Python+Flask开发的轻量级工具),其核心逻辑是通过模拟HTTP请求向微视服务器发送点赞指令。部署时,需将源码放置于Web服务根目录(如XAMPP的htdocs文件夹),通过修改配置文件(如config.php)中的数据库连接参数(localhost、root、空密码等),完成与本地数据库的对接。值得注意的是,此类工具的“模拟点赞”本质是向目标内容的API接口发送POST请求,需在代码中设置请求头(如User-Agent、Referer)以模拟真实浏览器访问,避免被识别为爬虫。

最后,模拟数据的生成是测试的核心。本地数据库需预先填充虚拟用户数据(如随机生成用户ID、昵称、设备指纹)与内容数据(视频ID、标题、发布时间)。可通过SQL脚本批量插入,或使用Python的faker库动态生成——例如模拟1000个虚拟用户,每个用户随机间隔5-30秒对同一视频进行点赞,验证工具在高并发下的稳定性。这一步直接关系到测试结果的真实性,需确保数据分布接近真实场景(如用户活跃时段、点赞频率的随机性)。

技术实现:模拟真实用户行为与反检测逻辑

微视的反作弊系统已具备成熟的行为分析能力,单纯的高频点赞极易被识别。因此,localhost上的刷赞网站需通过技术手段模拟“真人行为”,核心在于三个维度:请求特征的随机化、设备指纹的差异化与交互链路的完整性。

请求特征的随机化是基础。工具需为每次点赞请求生成不同的请求参数:例如IP地址可通过本地代理池轮询(如使用Charles代理模拟不同地区IP),时间戳需加入随机延迟(如1-10秒的浮动间隔),请求头中的User-Agent需从真实设备库中随机选取(覆盖iOS/Android不同机型)。这些细节能有效规避“请求模式固定”的异常检测。

设备指纹的差异化是关键。平台通过设备硬件特征(如IMEI、OAID)、浏览器缓存、Cookie等识别“异常账号”。本地测试可通过浏览器自动化工具(如Selenium)模拟真实用户操作:例如先打开微视官网浏览3-5秒(模拟内容消费),再点击视频进行点赞,最后随机滑动页面(模拟后续行为)。这种“非点赞单一操作”的交互链路,能显著提升模拟行为的可信度。

交互链路的完整性是进阶。真实用户的点赞往往伴随其他互动(如评论、分享)。本地工具可扩展功能模块,在点赞后随机触发“评论”(调用评论接口并插入预设文本)或“关注”(模拟关注目标账号),形成“点赞+评论”的组合行为。这种“多维度互动”的模拟,能让测试数据更贴近真实用户行为,验证工具在复杂场景下的稳定性。

应用场景:从技术调试到生态研究的价值延伸

localhost上的微视刷赞网站不仅是技术验证工具,更在多个场景中具备实用价值,为不同角色提供差异化支持。

对开发者而言,本地环境是功能迭代的高效“试验田”。例如,当工具需要适配微视新版API时,可通过本地抓包工具(如Fiddler)捕获真实点赞请求的参数结构,在localhost中模拟请求并调试响应逻辑,避免在公网环境中反复测试导致账号风险。这种“本地开发-验证-上线”的流程,能将工具迭代效率提升50%以上。

对内容创作者而言,本地测试可辅助优化内容策略。创作者可将已发布的视频数据(如点赞量、完播率)导入本地数据库,通过模拟不同用户画像(如新用户、活跃用户)的点赞行为,分析“点赞率”与“推荐量”的关联性。例如,测试发现“1000个新用户点赞”比“500个活跃用户点赞”更能触发算法推荐,创作者即可针对性调整内容触达新用户的策略。

对行业研究者而言,本地模拟是分析算法机制的“透明窗口”。通过控制变量法(如固定点赞量,调整点赞时间分布),观察本地数据模型中的“权重变化”,可反向推导微视算法对“点赞质量”的评估维度(如是否重视点赞用户的活跃度、内容相关性)。这种非侵入式的研究,为短视频平台的算法透明化提供了可行路径。

挑战与应对:技术迭代中的平衡之道

尽管localhost环境提供了安全可控的测试条件,但微视反作弊系统的持续升级仍对工具设计提出新挑战,需从技术、合规、数据三个维度应对。

技术上,平台可能通过“请求频率阈值”“设备指纹库更新”等方式提升检测精度。应对策略是动态更新模拟逻辑:例如引入“深度学习模型”(如LSTM网络)生成更自然的用户行为序列,或通过“联邦学习”技术,在多台本地设备间协同模拟用户行为,分散单设备请求压力。

合规上,需明确本地测试的边界——仅限技术研究,不可用于真实账号操作。开发者可在工具代码中加入“合规声明”,并通过本地防火墙限制工具仅允许特定IP访问(如127.0.0.1),避免被滥用。

数据上,本地模拟与真实环境仍存在差异(如网络延迟、服务器负载)。可通过搭建“本地-公网混合测试环境”:先在localhost验证基础逻辑,再通过小范围公网测试(如10个以内账号)验证真实场景下的稳定性,逐步缩小模拟与现实的差距。

localhost作为微视刷赞网站的“技术试验田”,其核心价值不在于“刷赞”本身,而通过本地化、合规化的测试,为短视频生态的技术研究与内容创新提供底层支撑。在平台规则与技术迭代的博弈中,唯有坚守合规底线、深耕模拟逻辑,才能让工具从“灰色地带”走向“价值创造”,最终推动短视频行业在健康、透明的轨道上持续发展。