卡盟下单作为数字交易生态中的关键环节,其稳定性直接关系到平台生存与用户信任。当前行业面临高并发冲击、数据安全风险、体验断层等多重挑战,全面维护与稳定运营需从技术底座、风控体系、用户服务、团队协同四大维度构建闭环能力,而非单点优化。本文将深入拆解卡盟下单全链路的维护逻辑,揭示稳定运营的核心方法论。

技术底座:高可用架构是稳定运营的基石

卡盟下单流程涉及支付网关、库存同步、用户鉴权、订单生成等多系统协同,任何单点故障均可能导致交易中断。全面维护的首要任务,是构建具备弹性伸缩能力的分布式架构。例如,采用微服务架构拆分下单模块,将支付、库存、用户服务等独立部署,通过API网关统一路由,避免“一荣俱荣,一损俱损”。在流量高峰期,自动触发弹性扩容机制,基于实时QPS(每秒查询率)动态增加应用服务器实例,确保下单响应时间稳定在200ms以内。

数据层需采用“主从复制+分库分表”策略,主库处理写请求(如下单扣款、库存锁定),从库承担读请求(如订单查询),并通过中间件(如Sharding-JDBC)实现水平拆分,规避单表数据量过大导致的性能瓶颈。缓存层面,引入Redis集群存储热点数据(如热门商品库存、用户购物车),设置合理的过期时间(如库存缓存TTL为30秒),并通过“缓存预热+主动更新”机制,避免缓存穿透与雪崩。此外,消息队列(如Kafka或RabbitMQ)需接入下单流程,实现异步解耦——支付成功后通过消息队列通知库存系统,避免同步调用导致的延迟累积。

风控体系:数据安全与风险防控是生命线

卡盟交易涉及资金流动与用户隐私,全面维护的核心是建立“事前预防-事中拦截-事后追溯”的全链路风控体系。数据安全层面,需落实“加密传输+存储隔离”:支付接口采用HTTPS+TLS 1.3加密,敏感数据(如身份证号、银行卡信息)通过AES-256算法加密存储,数据库访问通过IP白名单+动态令牌双重认证,防止数据泄露。

风险防控需结合规则引擎与机器学习模型。实时监控模块通过规则引擎识别异常行为,如“单IP10分钟内下单超50次”“同一设备切换3个支付账户”“订单金额与历史消费偏差超500%”等,触发人工复核或自动拦截;机器学习模型则基于历史订单数据训练风险画像,识别“黑产刷单”“洗钱交易”等隐蔽风险,准确率需保持在98%以上。此外,建立“黑名单-灰名单-白名单”三级信用体系,对高风险用户限制下单频次,对优质用户提供绿色通道,平衡风险控制与用户体验。

用户体验:流程优化与精细化运营是差异化竞争力

下单流程的流畅度直接影响转化率与复购率,全面维护需聚焦“减环节、降门槛、提效率”的用户体验优化。前端界面需遵循“极简原则”,减少非必要操作步骤——例如,支持“一键下单”(自动填充用户信息、默认选择常用支付方式)、“智能推荐”(基于历史消费优先展示高概率购买商品),移动端适配需确保按钮触控区域不小于48×48像素,避免误操作。

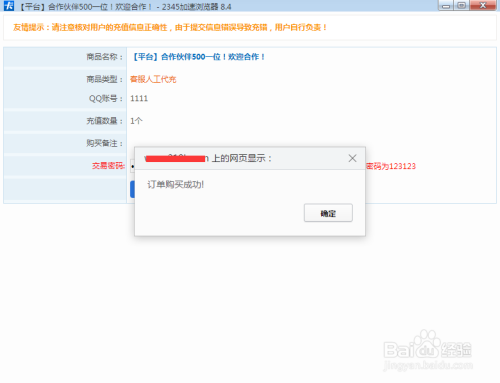

异常处理机制是体验优化的关键。当下单失败时,系统需返回具体原因(如“库存不足”“支付限额超限”),并提供解决方案(如“库存补货通知”“切换支付方式”),而非简单提示“错误”。同时,建立“自动重试+人工兜底”机制:对于网络波动导致的临时失败,系统自动重试3次(每次间隔1秒);重试失败后,触发客服主动介入(如电话回确认),避免用户流失。此外,通过埋点数据分析用户行为路径,定位流失节点(如“支付页跳出率过高”),针对性优化——例如,简化支付流程,接入微信、支付宝等主流支付方式,减少手动输入成本。

团队协同:标准化流程与应急响应是长效保障

稳定运营离不开高效的团队协作与应急机制。全面维护需明确技术、运营、客服的职责边界,建立“SOP+应急预案”双轨管理体系。技术团队负责系统迭代与故障排查,需制定《上线检查清单》(如接口联调、压力测试、数据备份),避免带病上线;运营团队监控订单数据波动,建立“日监控-周复盘-月优化”机制,及时调整营销策略(如高峰期限购、错峰促销);客服团队需掌握常见问题话术(如“订单延迟发货处理流程”),并通过工单系统与技术团队实时联动,缩短响应时间。

应急响应需分级处理:一级故障(如系统宕机、数据丢失)需在10分钟内启动应急预案,切换至备用服务器,并通过短信、APP推送通知用户;二级故障(如支付接口异常)需在30分钟内协调第三方服务商修复;三级故障(如页面样式错乱)需2小时内上线热修复补丁。此外,定期组织“故障演练”(如模拟服务器宕机、网络攻击),检验团队应急能力,确保“召之即来,来之能战”。

卡盟下单的全面维护与稳定运营,本质是技术、风控、体验、管理的深度融合。唯有将“稳定”内化为系统基因,将“用户”置于决策核心,才能在行业竞争中构建护城河。未来,随着AI、区块链等技术的应用,卡盟下单将向“智能风控”“无感支付”“个性化推荐”演进,但万变不离其宗——对稳定性的极致追求,对用户体验的敬畏之心,始终是平台长青的根基。