如何用js压缩文件和图片,提升加载速度?

在当代互联网的角逐中,页面加载速度早已超越了单纯的技术指标,演变为决定用户体验、转化率乃至SEO排名的核心要素。一个响应迟缓的网站,无异于在数字世界中为用户设置了一道无形的门坎。而在这场速度的竞赛里,JavaScript不仅仅是驱动页面交互的引擎,更是一把锋利的“手术刀”,能够对网站资源进行精细化的“瘦身”处理。利用JS进行文件与图片压缩,并非一项高深莫测的技巧,而是现代前端工程师必须内化于心的基本功,它直接关系到资源体积、网络请求耗时与浏览器渲染效率的最终表现。

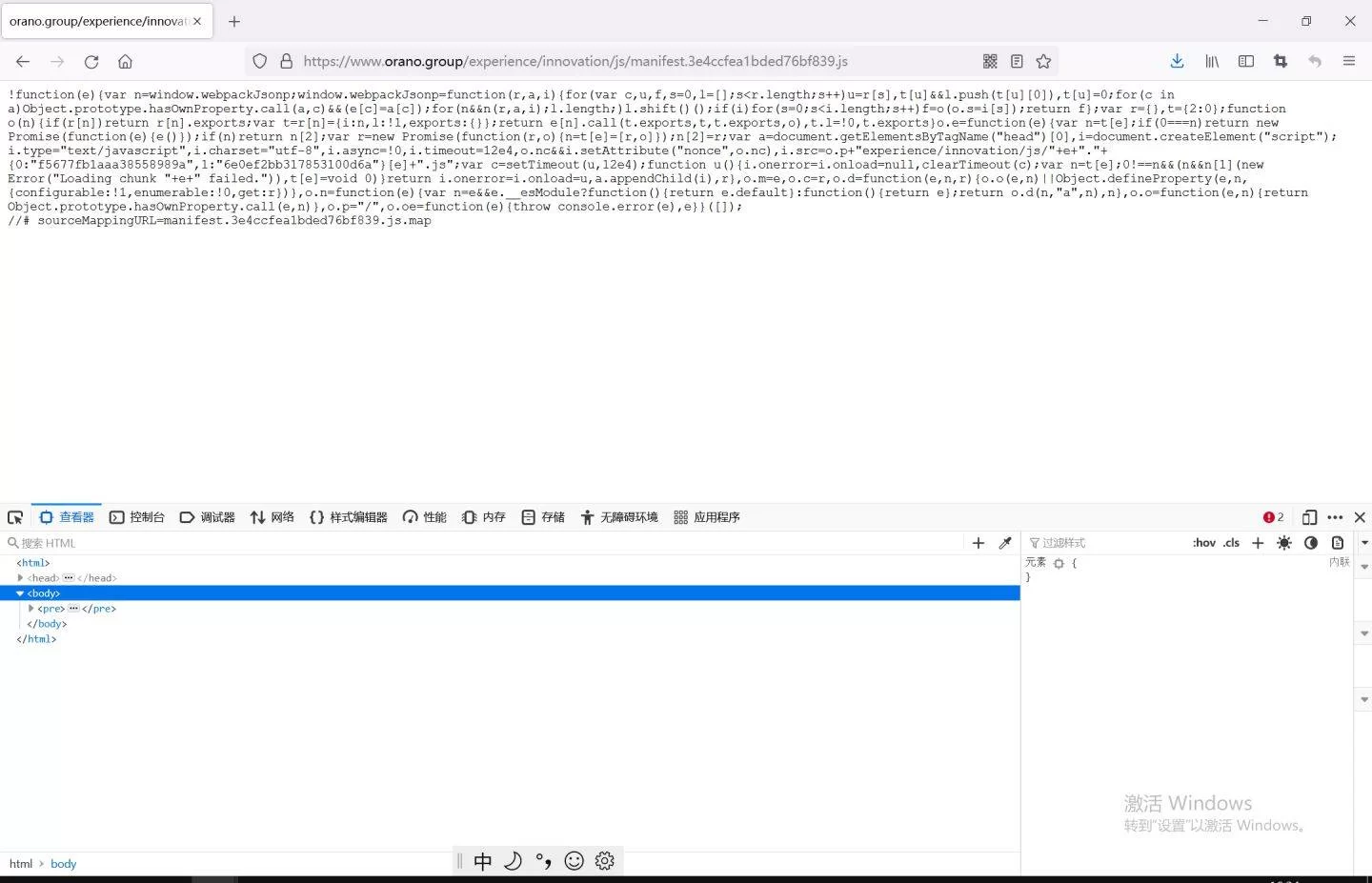

首先,我们来剖析JavaScript文件自身的压缩。这里的“压缩”远非简单的文件打包,它是一门涵盖语法分析与代码重构的艺术。其核心目标是在不改变功能的前提下,最大限度移除冗余字符,例如空格、换行、注释,并对变量名、函数名进行混淆,缩短其长度。更进一步的,是死代码消除(Dead Code Elimination),它能智能地识别并剔除那些在项目实际运行中永远不会被执行到的代码块,这在依赖大量第三方库的复杂项目中尤为关键。以Terser或曾经的UglifyJS为代表的工具,正是这一过程的执行者。当我们在进行JavaScript代码压缩工具对比时,会发现Terser作为新一代的压缩引擎,对ES6+语法的支持更为出色,其代码优化策略也更为激进。它不仅能理解作用域,避免因命名混淆导致的功能错误,还能进行表达式简化、控制流扁平化等深度优化。将这一过程自动化地集成到开发流中,是提升性能的第一步,也是最直接见效的一步。

然而,脚本文件往往只是页面“体重”的一部分,真正吞噬带宽的巨兽通常是图片。一张未经优化的高清图片,其体积可能是JS文件的数十甚至上百倍。因此,前端图片懒加载与压缩实现便成了性能优化的主战场。传统的做法依赖于后端或设计师在图片上传前进行处理,但这不仅增加了沟通成本,也缺乏灵活性。JavaScript赋予了我们前端直接操控图片的能力。通过元素和FileReader API,我们可以在用户上传图片的瞬间,于浏览器端完成压缩。这涉及到将图片绘制到Canvas上,再通过toDataURL()或toBlob()方法导出,并在此过程中指定一个较低的质量参数。诸如compressor.js等现成的库,将这一复杂过程封装得极为友好,开发者只需几行代码就能实现图片的客户端压缩,极大地减轻了服务器的压力与用户的上传等待时间。这种浏览器端JS实时压缩图片上传的模式,在用户生成内容(UGC)平台中,价值不言而喻。

除了减小单张图片的体积,选择更高效的图片编码格式同样是关键一步。JPEG与PNG虽然经典,但在压缩效率上已显疲态。新兴的WebP格式,由谷歌推出,在同等画质下,其体积通常比JPEG小25%-35%。而更前沿的AVIF格式,压缩比更是惊人。JavaScript在其中扮演的角色,是进行“格式转换”与“智能降级”。我们可以利用JS检测浏览器对WebP或AVIF的支持情况,并动态地生成srcset属性提供不同格式的图片源。一个完整的WebP格式转换与JS压缩方案,通常结合了后端服务(如使用Sharp库进行实时转换)与前端的动态决策能力,确保在所有终端上都能加载到体积最小且兼容性最佳的图片资源。

当我们将代码压缩与图片优化视为独立的优化点时,已经能获得显著的性能提升。但真正的效能飞跃,来自于将它们与加载策略相结合。懒加载便是其中的佼佼者。它的逻辑非常直观:非首屏、非关键的资源,何必急于一时?过去我们依赖滚动事件监听和各种复杂的偏移量计算,性能开销不小。如今,现代浏览器提供的Intersection Observer API,为前端图片懒加载与压缩实现提供了近乎完美的解决方案。它以一种异步、高效的方式,观察目标元素是否进入视口,一旦进入,便触发加载。这意味着,我们可以将压缩后的图片资源,配合懒加载策略,做到“按需分配”,将宝贵的初始加载带宽完全留给首屏关键内容,让用户能以最快的速度“看到”页面的核心信息。

将这些零散的优化手段整合成一个高效、自动化的流水线,就需要构建工具的介入。在众多工具中,Webpack无疑是当今生态最成熟、功能最强大的存在。使用Webpack优化资源加载性能,远不止是调用一个插件那么简单。Webpack扮演的是一个“总指挥”的角色。它通过Loader机制,能让.js文件在打包时自动经过TerserPlugin进行压缩和混淆;能让图片、字体等静态资源被file-loader或url-loader处理,甚至可以内联为Base64编码,减少HTTP请求。更重要的是,Webpack的代码分割功能,能够将庞大的业务代码拆分成多个chunks,实现按需加载,与路由懒加载无缝衔接,从根本上杜绝了无用代码的预加载。配置Webpack的过程,本身就是一次对项目资源加载路径的深度审视与重构,它将前端的性能优化从“手动挡”时代带入了“自动挡”时代。

最后,必须清醒地认识到,前端的努力并非故事的全部。当客户端请求到达服务器时,我们还有最后一道防线可以启用:服务器端的动态压缩。常见的有Gzip和Brotli。它们的工作原理与前端JS压缩不同,是基于文本的通用压缩算法。Gzip与Brotli压缩JS文件差异主要在于压缩率和CPU消耗。Brotli作为后起之秀,通常能比Gzip提供高出15%-20%的压缩率,意味着传输到用户浏览器中的文件更小,但它在压缩时对服务器的CPU资源占用也相对更高。对于绝大多数现代CDN服务商来说,启用Brotli已经是一项标准配置,开发者只需在控制台轻轻一点,就能享受到这“免费的午餐”。将前端的精细化(代码/图片压缩)与后端的粗放式(Gzip/Brotli)相结合,才能构建起一张从源头到终点的性能优化网络。

性能的优化,是一场没有终点的马拉松。它要求我们既要像艺术家一样精雕细琢每一行代码、每一张图片,又要像战略家一样规划整个资源的加载蓝图。利用JavaScript进行文件与图片压缩,正是这场马拉松中我们手中最核心的装备之一。它将优化的主动权交给了前端开发者,让我们能够更贴近用户、更即时地响应性能需求。这并非一次性的任务,而是一种持续演进、不断探索的工程文化,是开发者对用户体验最直接、最深沉的敬意。