打码看不清字?怎么才能看清打码的字?

在数字信息的洪流中,我们时常会遇到被刻意遮蔽的内容——那些模糊不清的马赛克、漆黑一片的色块或是交错的黑白条纹。好奇心驱使我们发问:这些被打码的字,真的有办法看清吗?这个问题背后,既包含着对技术极限的探索,也触及了信息安全与个人隐私的核心地带。要彻底理解这个问题的答案,我们必须首先抛弃影视剧中那些鼠标一点、画面瞬间清晰的“神技”,回归到数字图像处理的本质,去探寻打码技术那不可逾越的边界。

打码,从其技术本质上讲,并非是在原始信息上覆盖了一层“遮羞布”,而是一种对原始信息的毁灭性操作。我们可以用一个简单的比喻来理解:想象一张写满重要信息的纸张,打码操作就像是将其中需要保密的部分用碎纸机彻底粉碎。无论你事后如何努力,都无法从那一堆碎纸屑中精确地拼凑回原来的字句,因为承载信息的物理结构已经被不可逆地破坏了。在数字图像领域,这个过程更为彻底。以最常见的像素化马赛克为例,它将一个区域内原本色彩、亮度各不相同的多个像素点,用一个统一的、由单一颜色或平均颜色构成的更大色块来替代。这个过程瞬间就抹去了成百上千个原始像素点的独立数据,取而代之的是一个全新的、高度概括的数值。原始图像的精细纹理、边缘细节等高频信息在这一过程中被大量丢弃,这在信息论中被称为信息熵增,是一个从有序到无序的不可逆过程。同样,高斯模糊打码则是通过卷积核运算,将周围像素的颜色值进行加权平均,使得目标区域的像素值“污染”了彼此,同样造成了原始信息的永久性丢失。

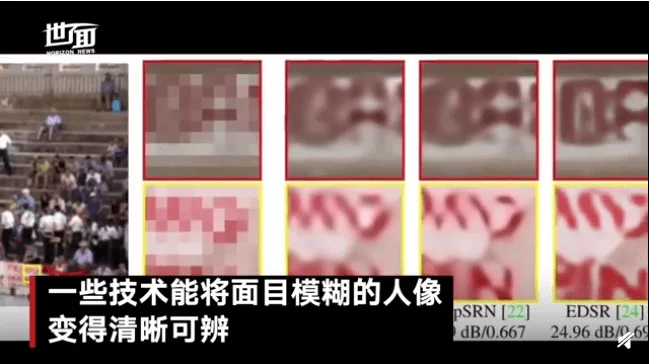

既然原始数据已经丢失,那么市面上流传的那些所谓“去马赛克”软件又是怎么回事呢?这恰恰是问题的关键所在,也是最容易产生误解的地方。我们必须清醒地认识到,目前没有任何一种技术能够“恢复”被标准马赛克彻底破坏的原始信息。那些声称能做到的工具,其背后运作的原理并非“恢复”,而是“猜测”与“生成”。它们大多基于人工智能,特别是深度学习中的图像修复或图像生成模型。这些模型在海量的数据集上进行了训练,学会了“理解”图像内容。当你输入一张带有马赛克的图片时,AI会根据马赛克周围区域的上下文信息,去推测被遮挡区域最可能的内容是什么。例如,如果马赛克遮挡的是人脸的一部分,AI会根据露出的眼睛、头发、轮廓,生成一个看起来最“合理”的五官;如果遮挡的是文字,AI会根据前后文的语义和字形,生成一个最“通顺”的词语。然而,这终究是AI的创作,而非事实的还原。它生成的人脸,并非原始照片中那个人;它生成的文字,也绝非原始文档里的那个词。这种技术在艺术创作、老照片修复等领域确实有其价值,但在用于“看清”被加密信息时,其结果充满了不确定性,甚至可能产生误导性的、完全错误的结论。

那么,是否在任何情况下,被遮挡的信息都绝对无法复原呢?答案也并非完全绝对,但这取决于“打码”的方式是否专业。在一些非标准的、不彻底的“打码”操作中,确实存在一丝可能性。比如,有人仅仅是使用画笔工具涂上了一个半透明的黑色图层,或者是在一个可编辑的文档软件(如Photoshop、Word)中添加了一个遮挡色块但并未合并图层。在这些情况下,原始信息依然完好无损地存在于底层,我们需要的不是“破解”技术,而仅仅是“撤销”操作——删除那个上层色块或调整图层透明度即可。但这已经不属于“反打码”的范畴,而是操作失误的补救。真正严谨的、用于保护隐私的打码,在操作完成后都会将图像“扁平化”或“栅格化”,形成一个不可再编辑的最终图像文件,从而彻底杜绝了被轻易撤销的风险。

从更宏观的视角来看,打码技术的存在与演进,是数字文明社会不可或缺的基石。它不仅是个人保护隐私、维护尊严的工具,更是企业、机构乃至国家在信息时代保障数据安全的重要手段。从个人在社交媒体分享生活时对家人面部的模糊处理,到企业在发布财报时对敏感数据的遮盖,再到政府公开文件时对公民个人信息的保护,打码无处不在。它背后所依赖的,是一整套成熟的信息加密与隐私保护技术体系。这些技术的发展,旨在构建一个信任的数字环境,让信息在流动与共享的同时,其核心机密与个人隐私能够得到坚不可摧的守护。因此,当我们执着于“如何看清打码的字”时,或许更应该思考一个问题:为什么这些信息需要被打码?尊重这种“不可见”,本身就是对他人权利的尊重,是对社会规则的遵守。

对马赛克背后内容的探寻,本质上反映了人类对未知的好奇与对确定性的追求。然而,在数字世界中,有些“模糊”并非缺陷,而是设计的精髓,是秩序的保障。与其耗费心神去挑战那些由数学和物理定律铸就的技术壁垒,不如将目光投向如何更好地运用这些技术来保护我们自己,如何在信息自由与安全隐私之间找到那个精妙的平衡点。我们真正的任务,不是去刺破每一层合法的遮蔽,而是学会理解并尊重这些边界,共同构筑一个更加安全、可信且充满人文关怀的数字文明。